Viggle AI:a16z领投1900 万美元A轮融资,AI改变角色动画

文章来源:共同虚拟

原文链接:https://mp.weixin.qq.com/s/CG6CJDou91I22ST7u_Qa3Q

加拿大初创公司Viggle AI近期宣布已在由 Andreessen Horowitz ( a16z ) 领投的 A 轮融资中筹集了 1900 万美元,其他投资者Two Small Fish也参与其中。

Viggle AI 由 华人创业者Hang Chu 于 2022 年创立,致力于通过生成式AI改变角色动画。

此轮融资将使 Viggle AI 能够继续扩大规模、加速产品开发、扩大团队并巩固其在可控视频生成和 AI 动画领域的领先地位。

新一轮融资正值该公司爆炸式增长之际。

今年早些时候,Joaquin Phoenix扮演的小丑取代说唱歌手 Lil Yachy在夏季 Smash 音乐节上退场的视频开始在互联网上流传,Viggle AI 的强大功能因此而声名鹊起。

Viggle 由 Hang Chu 创办,并担任首席执行官。他在科技和娱乐领域的经验为 Viggle 的早期成功、战略方向和利用 AI 制作动画内容的愿景做出了贡献。在加入Viggle之前,Chu 曾在 AutoDesk、Facebook 和 NVIDIA 任职。

Viggle AI 成立的初衷是简化动画流程,让用户使用简单的文本转视频或图像转视频提示即可创建逼真的动画。

自上半年视频出圈开始,从专业动画师、主要流媒体和制作工作室到内容创作者、模仿者和业余爱好者,该平台吸引了数百万用户的关注,Viggle AI 已经在 Discord 上建立的社区,迄今为止吸引了 400 万名成员。

对于专业动画工程师、游戏设计师和视觉特效艺术家来说,Viggle AI 简化了构思和前期制作流程,使他们能够专注于自己的创意愿景,并最终缩短制作时间。对于内容创作者和日常用户来说,Viggle 可以使用简单的提示生成高质量的动画,在几分钟内制作出引人入胜的动画角色视频。

Viggle AI 日前还推出了Viggle Creator 计划,该计划的会员可获得 Viggle Pro 订阅、额外的 1,000 个积分(相当于 250 分钟的视频)、新功能的早期使用权,以及通过独家社区渠道与其他创作者建立联系的机会。该计划旨在支持新兴人才和成熟的专业人士突破 AI 动画的界限。

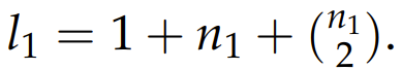

该公司在新闻稿中声称,其专有的 JST-1 技术是第一个基于对物理学的真正理解而构建的视频 3D 基础模型,可以创建逼真的角色动作。

谈到Viggle 与其他 AI 视频模型之间的主要区别,Viggle 首席执行官 Hang Chu 表示,Viggle 允许用户指定他们希望角色采取的动作。其他 AI 视频模型通常会创建不切实际的角色动作,这些…

Viggle 目前在 Discord 和其网络应用上提供其 AI 模型的免费、受限版本。除了创作者计划为一些创作者提供特殊访问权限,该公司还提供 9.99 美元的订阅版。

Chu 表示,Viggle 正在与电影和视频游戏工作室商谈授权该技术,但他也看到独立动画师和内容创作者正在采用该技术。

创始人和投资人观点

Viggle AI 首席执行官兼联合创始人 Hang Chu 表示:“我们很高兴欢迎 a16z 和 Two Small Fish 成为我们下一阶段增长的合作伙伴。他们的投资不仅肯定了我们的愿景,还使我们能够重新定义 AI 驱动的角色动画的可能性。随着越来越多的人寻求整合 AI 以实现更愉快、更易于访问的创作过程,Viggle 通过结合构建和扩展 AI 的最佳方法来帮助无缝满足消费者需求。我们期待将我们的技术覆盖范围扩大到更广泛的受众,并扩大每个人的创造力边界。”

Andreessen Horowitz 今年早些时候表示,已投入约 22.5 亿美元用于 AI 基础设施和应用投资。Andreessen Horowitz 合伙人 Justine Moore 谈到这笔最新投资时表示:“Viggle AI 正在推动内容创作者在角色和场景一致性创作方面发生重大转变。Viggle 的早期发展势头和已经实现的用户群给我们留下了深刻的印象,我们迫不及待地想看看他们的持续创新将带我们走向何方。”

Two Small Fish 运营合伙人、加拿大人工智能故事讲述公司 Wattpad 联合创始人兼前首席执行官 Allen Lau 补充道:“Viggle 代表着内容的未来,它将像 Wattpad 一样颠覆娱乐行业。作为顾问,我将根据自己从头开始构建全球娱乐平台的实际经验提供指导。我很高兴能与 Viggle 一起进一步颠覆娱乐行业,并改变生成式人工智能时代内容的创作和混编方式。—

感谢阅读!如果您对AI的更多资讯感兴趣,可以查看更多AI文章:GPTNB。